中文 / 英文

中文 / 英文

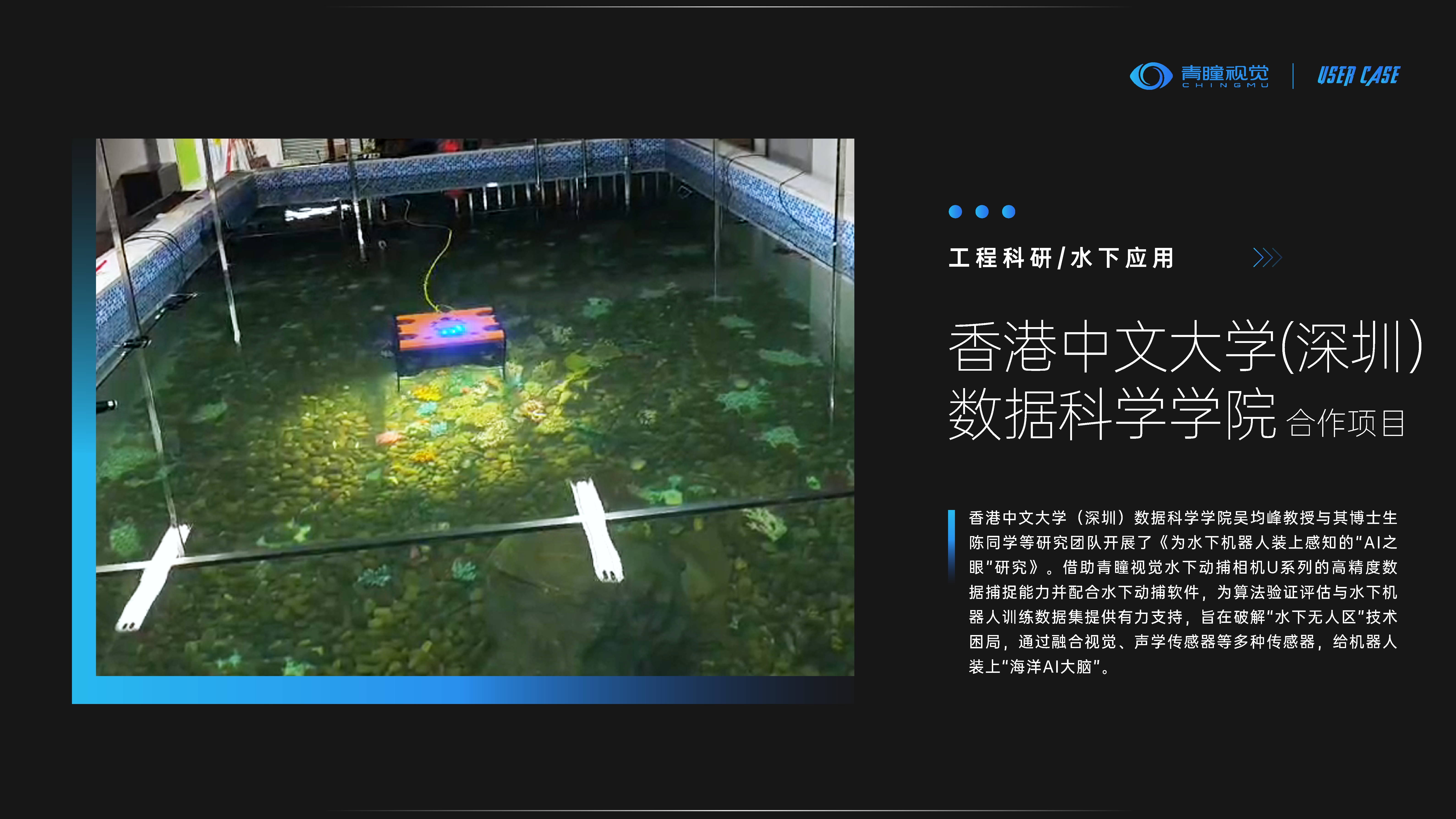

香港中文大学(深圳)数据科学学院

为水下机器人装上感知的“AI之眼”

为解决上述问题,香港中文大学(深圳)数据科学学院吴均峰教授与其博士生陈同学等研究团队开展了《为水下机器人装上感知的“AI之眼”研究》。借助青瞳视觉水下动捕相机U系列的高精度数据捕捉能力并配合水下动捕软件,为算法验证评估与水下机器人训练数据集提供有力支持,旨在破解“水下无人区”技术困局,通过融合视觉、声学传感器等多种传感器,给机器人装上“海洋AI大脑”,让机器人能够在复杂的水下环境中进行自主导航和任务执行,为AI技术在海洋领域的应用注入新的可能。

一、研究方案

针对水下真实数据采集成本高昂、数据稀缺的核心痛点,研究团队创新性地采用仿真技术模拟水下感知环境,为算法迭代提供数据支撑。具体方案包括:

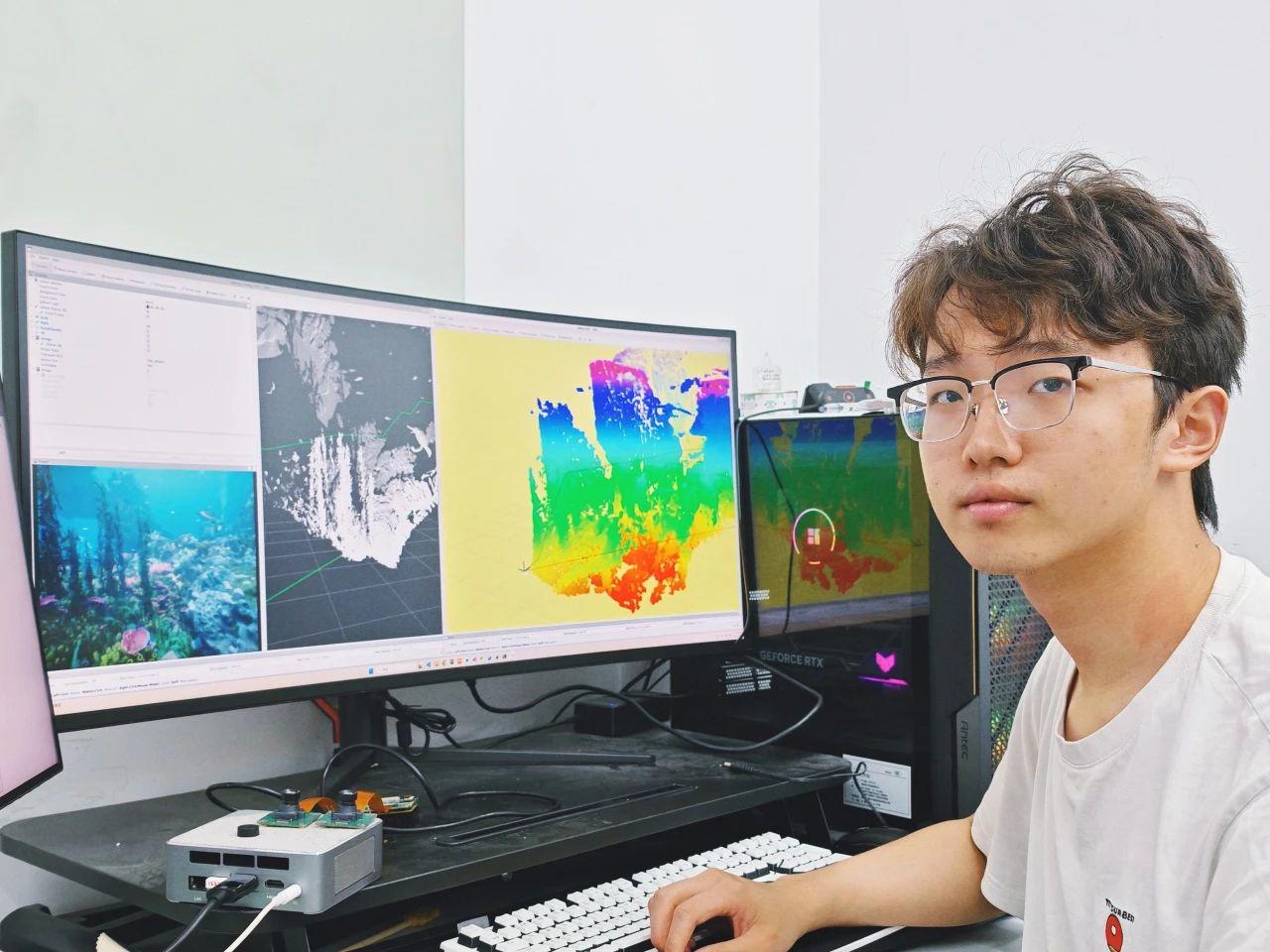

- UE5 仿真测试平台搭建:博士生陈同学基于UE5构建了全面的仿真测试平台,利用UE5先进的物理引擎和渲染系统,生成高度逼真的海底场景,包括复杂地形、珊瑚水草等植被和沉积物等细节。系统能够模拟不同浑浊度的水下环境,并实时输出高质量的深度图像和模拟声呐数据,这为快速验证水下机器人的感知、定位、导航算法提供了仿真基础。

海底环境三维重建:在仿真平台基础上,团队开发了基于神经网络模型,结合机器人对海床环境的先验知识和时序上的历史信息,实现了从二维声呐数据到三维空间理解的跨越;同时,系统通过里程计对获取的传感器信息进行空间配准,实现对复杂海底环境的三维重建。

二、实验验证

研究团队通过声呐定位与多模态感知两项核心实验,验证技术有效性,推动深海自主探测技术突破:

- 声呐定位实验

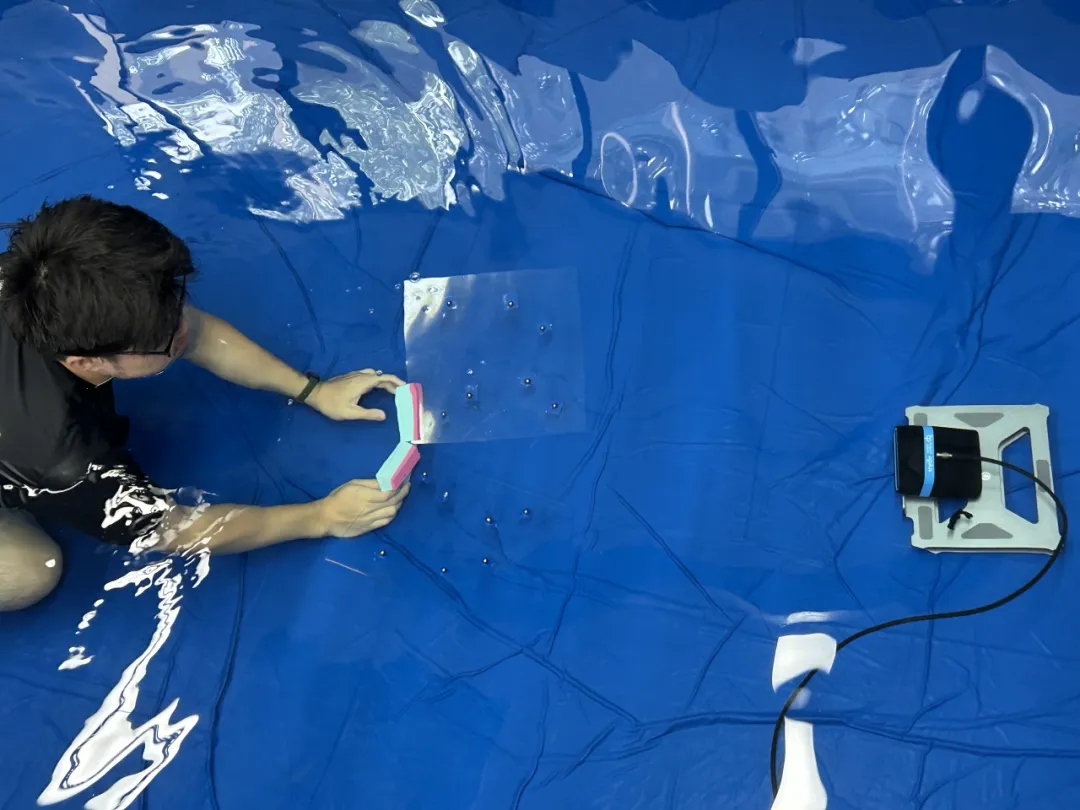

实验设计:在实验室的方形试验池底铺设带有精密反声学结构的标定装置,搭载前视成像声呐的机器人对其进行扫描,同时持续发射高频声波信号并采集反射特征。

算法验证:机器人沿预设的“8”字形及“LIAS”(吴均峰教授领导的智能自主系统实验室“The Laboratory for Intelligent Autonomous Systems”的英文缩写)字样轨迹运动,轨迹设计包含连续急转、惯性滑行等典型运动模态。借助机器人在这类复合路径产生的各向位姿变化,并利用青瞳视觉水下动捕相机U系列配合水下动捕软件,帮助研究团队获取到机器人的相关位姿与轨迹真值,从而全面验证定位算法在急转、急停等复杂运动状态下的位姿解算精度。

研究团队采用青瞳视觉水下动捕系统进行机器人运动轨迹算法验证

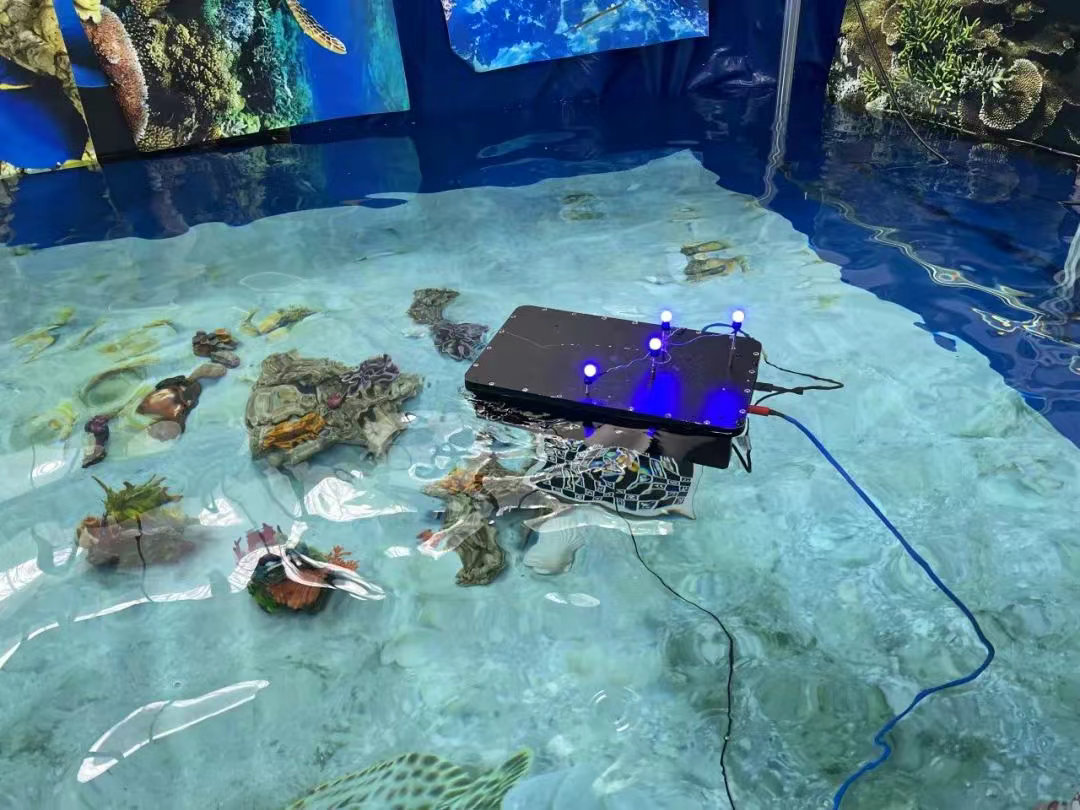

多模态感知实验

- 实验设计:相邻实验区被打造为微缩海底环境,以细沙为基底,分布3D打印的海洋生物群落与礁石结构。

- 实验验证:

- 在螺旋轨迹绕行礁石时,凭借青瞳视觉光学动捕相机毫秒级响应特性捕捉水下动态光场变化;

- 匀速巡航阶段,多普勒测速仪(DVL)实时测量对底速度并同步构建三维点云;

- 进入重点勘测区域后,机器人启动十字模式——沿正交轴线执行往复扫描,实现光学影像与声学特征的空间配准。

装备多传感器套件的机器人执行精密探测程序——

单次实验可采集超过50GB的多源异构数据,辅以水下动捕的真实位姿数据作为监督指标,这些数据正被用于训练新一代多模态感知融合算法,目标是为深海机器人构建“声—光联合感知”智能系统。

- 实验总结

- 声纳与多模态传感器融合实验使用青瞳视觉水下动捕系统采集到的动捕数据作为真值,评估自研算法的精度与效果。

青瞳视觉动捕系统为水池数据集提供真值支撑,方便使用者评判自己算法的在数据集中的表现。